KI hat keine eigene Haltung!

Aber sie trägt viele Haltungen in sich – weil sie die Werke anderer verschmilzt, in denen jeweils eine menschliche Haltung steckt.

TechToons

Handgezeichnete Cartoons und Erklärbilder zur Künstlichen Intelligenz: Modelle, Anwendungen, Chancen und Risiken in Bildung und Wirtschaft.

Künstliche Intelligenz wirkt sauber, smart und autonom.

Doch hinter der glatten Oberfläche arbeiten Millionen Menschen im Verborgenen – als Datenannotator:innen.

Ausgelagert, schlecht bezahlt, psychisch belastet.

Sie klassifizieren Bilder, bewerten Texte, filtern Gewalt.

Ohne sie könnten Maschinen nichts erkennen, nichts verstehen, nichts leisten.

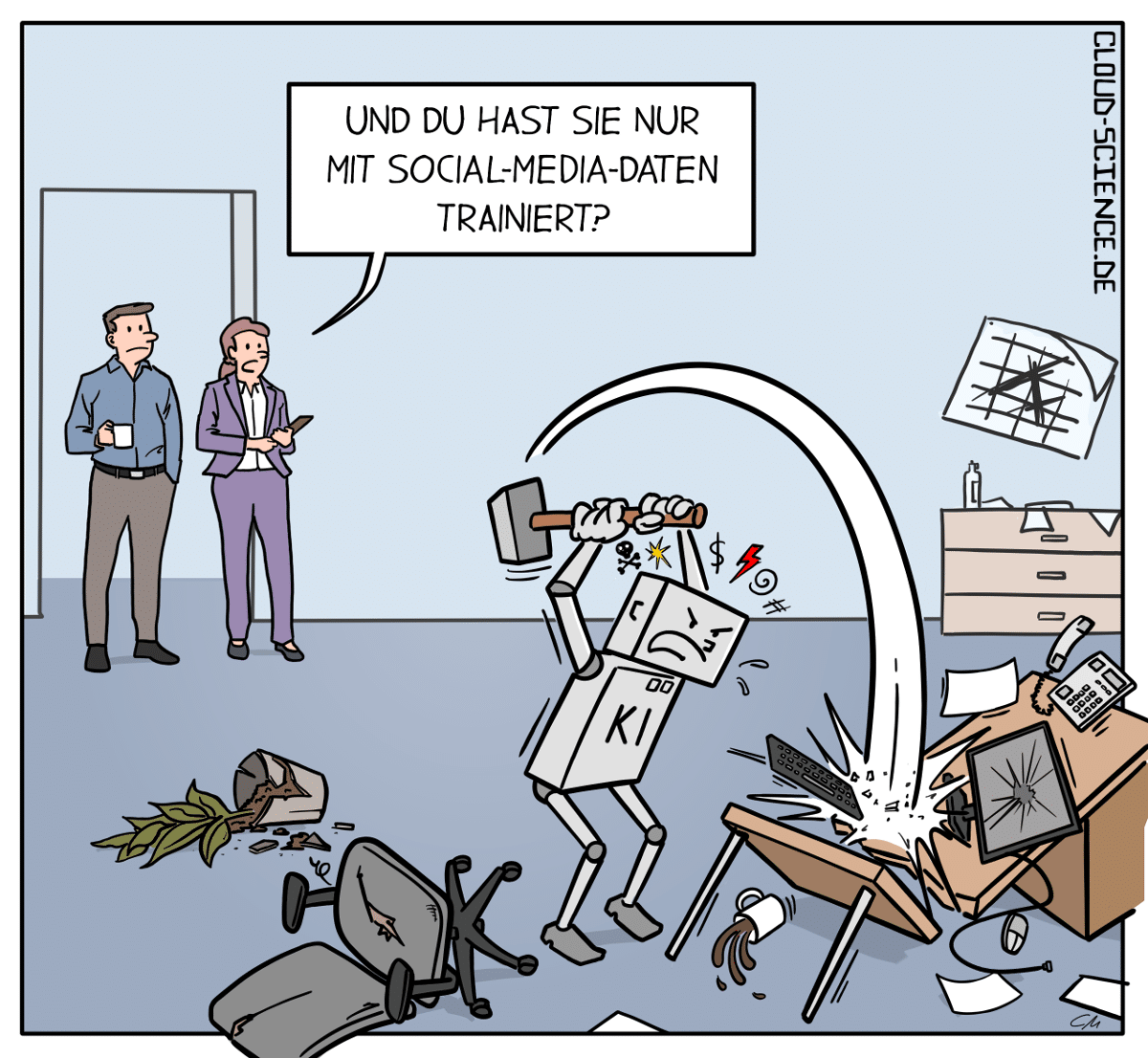

Ein Cartoon zeigt eine KI, die im Büro durchdreht – trainiert mit Social-Media-Daten, die alles andere als neutral oder objektiv sind.

Denn was in sozialen Netzwerken dominiert, ist oft emotional, populistisch, toxisch oder schlichtweg belanglos. Wenn eine KI daraus „lernt“, übernimmt sie die verzerrten Weltbilder – mit fatalen Folgen.

Das Motiv steht für ein reales Problem in der Entwicklung von KI-Systemen: Die Qualität und Herkunft der Datenbasis. Wenn diese verzerrt, lückenhaft oder oberflächlich ist, entstehen Risiken: algorithmische Fehlentscheidungen, Fehleinschätzungen und Kontrollverlust.

Ein zugespitztes Motiv für Präsentationen, Keynotes oder Fortbildungen zu den Themen AI Ethics, Datenqualität, Machine-Learning-Risiken oder Social Media als Datenquelle.

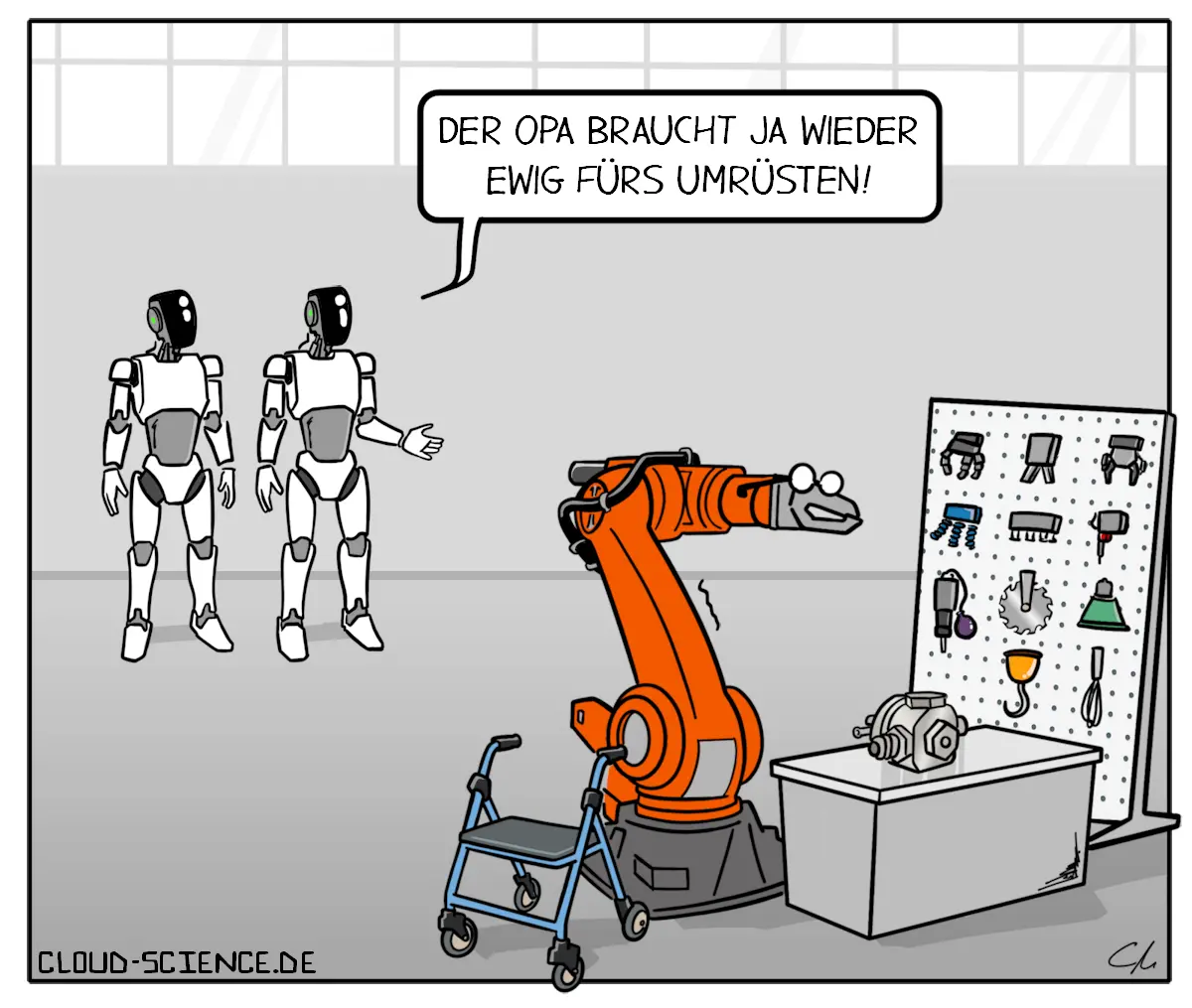

Humanoide Roboter verändern die Art und Weise, wie wir in der Fertigung arbeiten. Mit ihrer Flexibilität, Schnelligkeit und Kosteneffizienz durch weniger Stillstandzeiten setzen sie neue Maßstäbe für die Produktion von morgen.