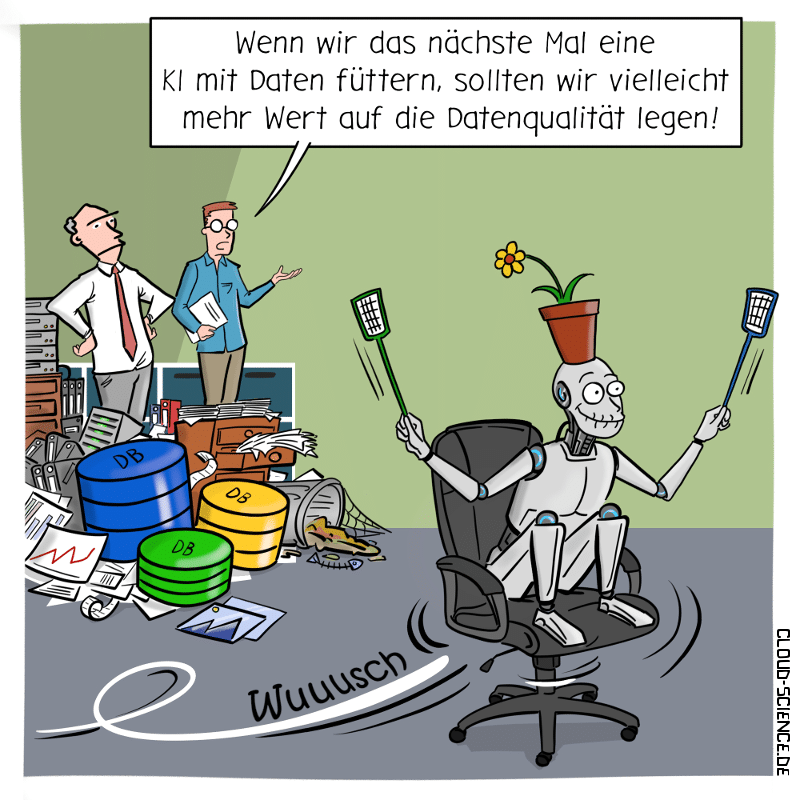

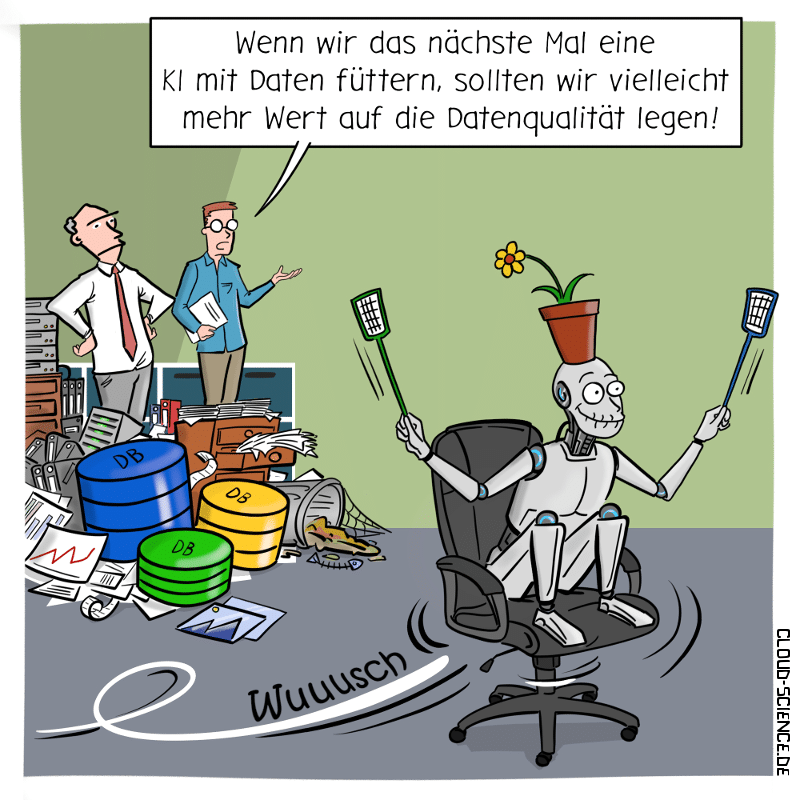

Merke: Ohne eine gute Datenqualität nützt mir auch die tollste KI nichts!

TechToons

Merke: Ohne eine gute Datenqualität nützt mir auch die tollste KI nichts!

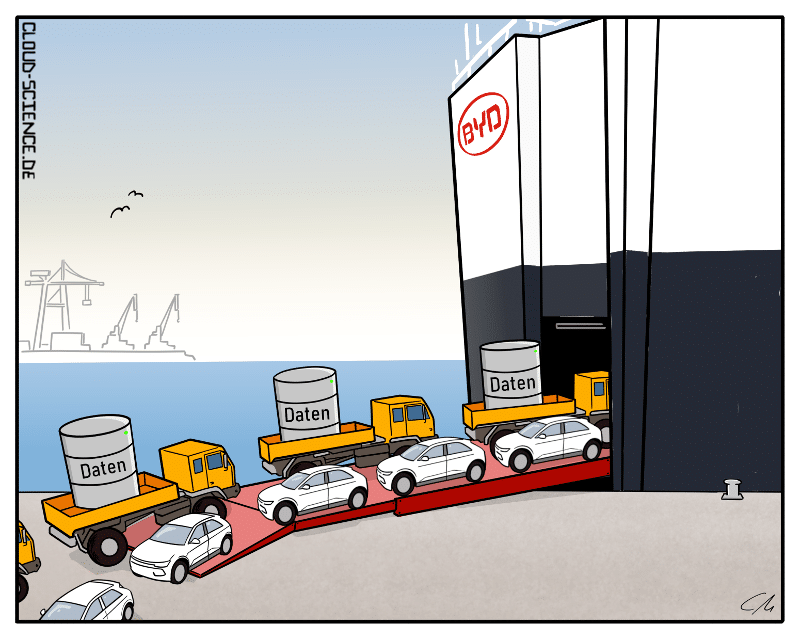

Die gigantischen BYD-Autofrachter haben Europa erreicht.

Doch Vorsicht! Chinesische Autos sind große Datensammler und damit eine echte Herausforderung für unseren Datenschutz.

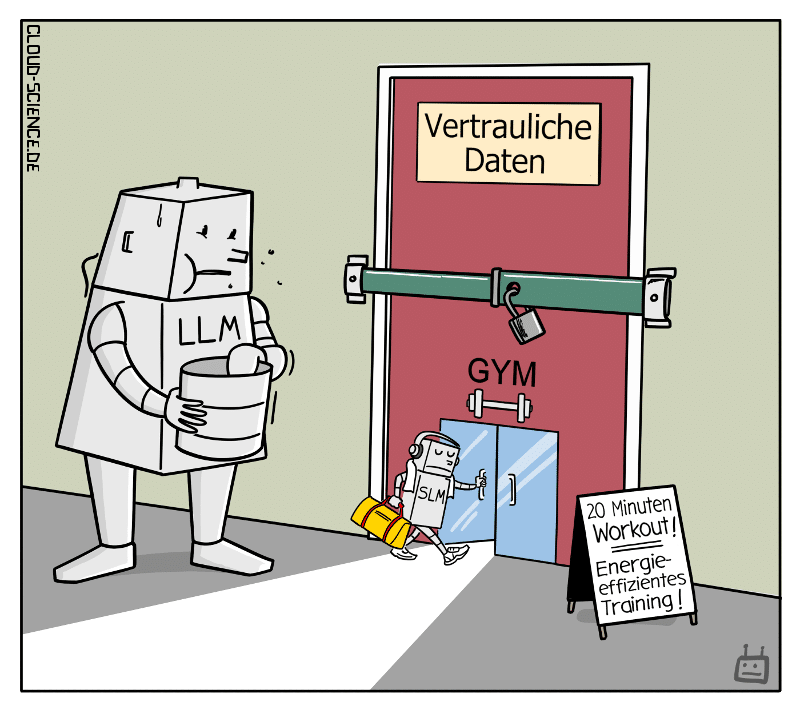

Als KI-Sprachmodelle bieten Small Language Models (SLMs) effiziente Datenschutzlösungen, beschleunigtes Training und Energieeffizienz. Im Vergleich zu Large Language Models (LLMs) läuten sie eine neue Ära für den Einsatz in sensiblen Bereichen ein.

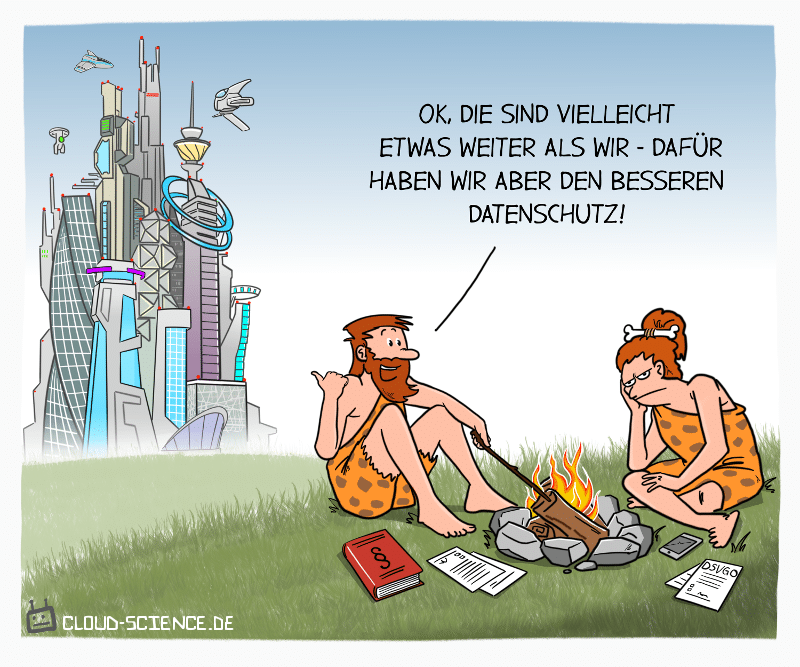

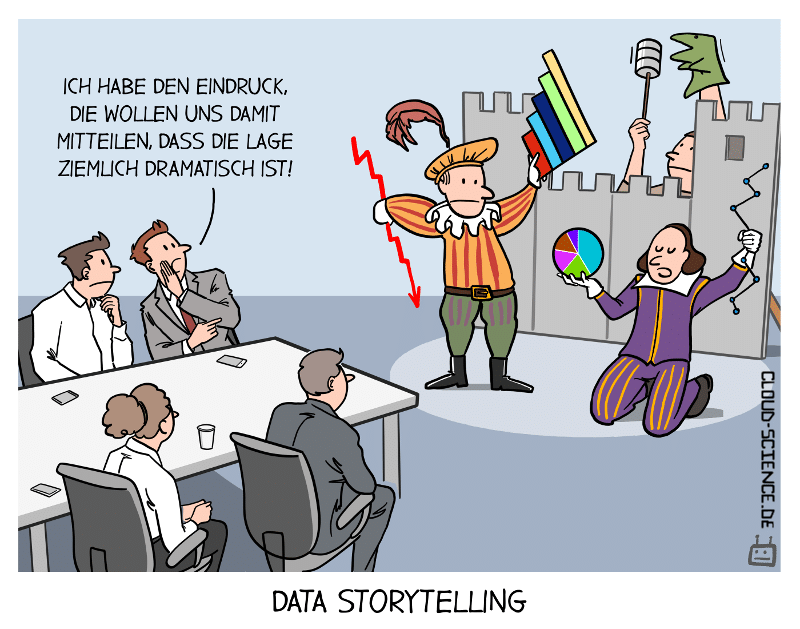

Europas strenge Datenschutzgesetze können den Einsatz von KI einschränken und somit zu einem Nachteil der Innovationsfähigkeit führen. KI benötigt große Datenmengen zum Lernen, und strenge Datenschutzgesetze könnten den Zugang zu diesen Daten erschweren.

Es besteht die Sorge, dass Europa im globalen Wettbewerb der KI-Weltmächte zurückbleibt und Innovationen verpasst, während andere Länder eine unvorstellbare Macht im Bereich KI erlangen könnten.

Es gilt, die Vorteile von Datenschutz und Innovation gleichermaßen zu berücksichtigen und ein ausgewogenes Verhältnis zwischen beiden zu finden, um das volle Potenzial von KI auszuschöpfen und gleichzeitig die Privatsphäre und personenbezogenen Daten zu schützen.

Hoffen wir, dass andere auch so denken…

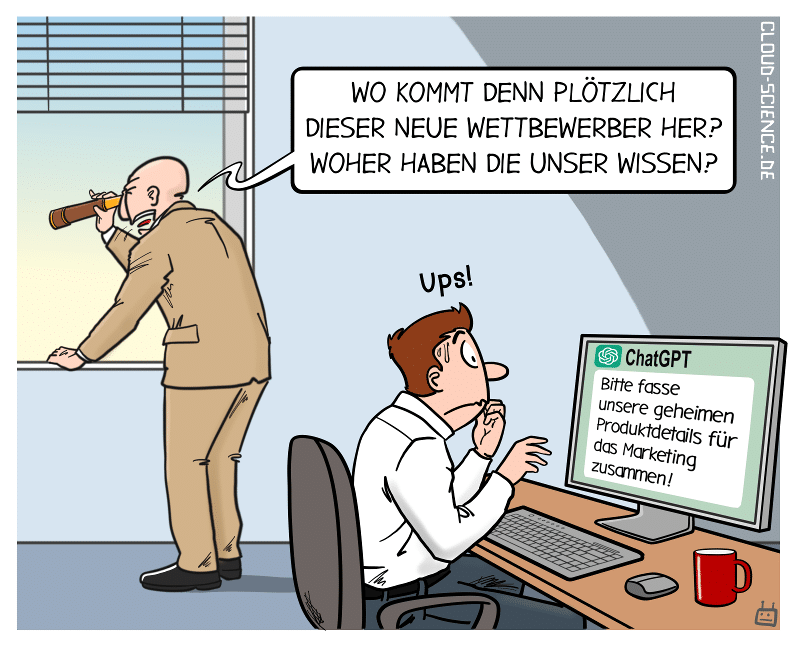

…bleiben besser Betriebsgeheimnisse!

Wenn du ChatGPT mit sensiblen Daten fütterst, kannst du schnell in Schwierigkeiten geraten. Die Daten können von OpenAI verwendet, verkauft oder für eigene Produkte umgesetzt werden. Du weißt nie, wer Zugriff auf deine Daten hat oder was damit passiert.

Es ist wichtig, sicherzustellen, dass du nur relevante und notwendige Informationen teilst und ChatGPT nicht mit vertraulichen oder geschützten Daten fütterst. Sei vorsichtig und bewahre die Kontrolle über deine Daten!

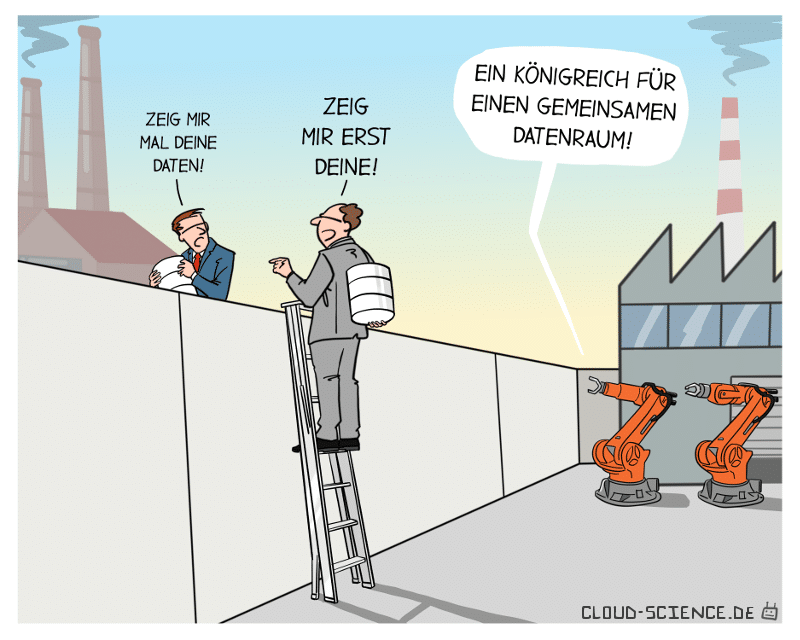

Manufacturing-X ermöglicht die Vernetzung von Unternehmen im industriellen Sektor, um Abläufe transparenter zu gestalten. Manufacturing-X fungiert als Datenraum, welcher auf gemeinsamen Regeln und Standards basiert und den Austausch von Daten in einer offenen Umgebung ermöglicht.

Bisher gab es nur einen punktuellen Datenaustausch, der das Teilen von Daten entlang der Lieferkette erschwerte. Doch mit Manufacturing-X wird das Datenteilen deutlich einfacher und die Zusammenarbeit von Wertschöpfungsnetzwerken optimiert. So können Unternehmen schnell auf Störungen in Lieferketten reagieren, die Produktion anpassen und Lieferverzögerungen vermeiden.

Zudem ermöglicht Manufacturing-X neue, datenbasierte Geschäftsmodelle in der Industrie.

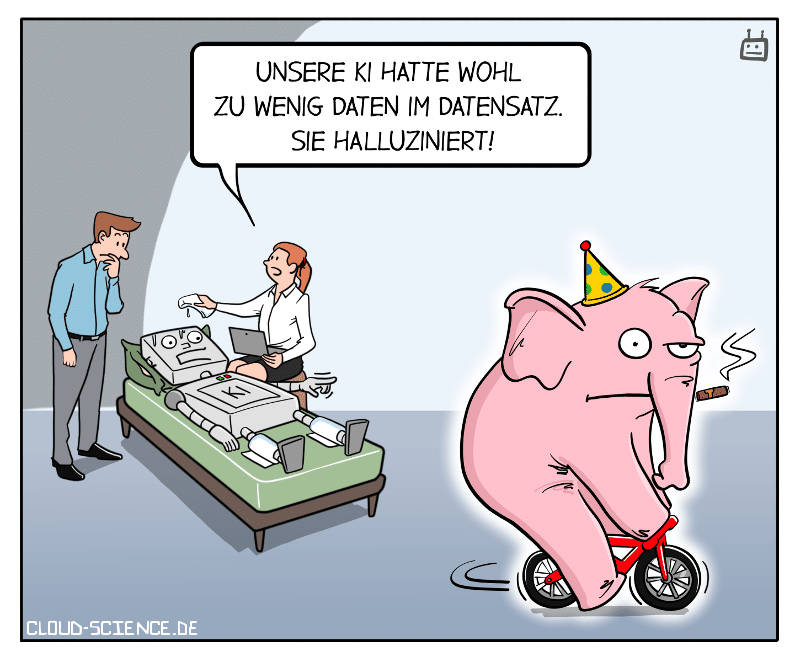

KI-Chatbots wie ChatGPT und Bard übernehmen immer mehr Aufgaben wie das Schreiben von Briefen, das Lösen von Aufgaben und das Generieren von Inhalten.

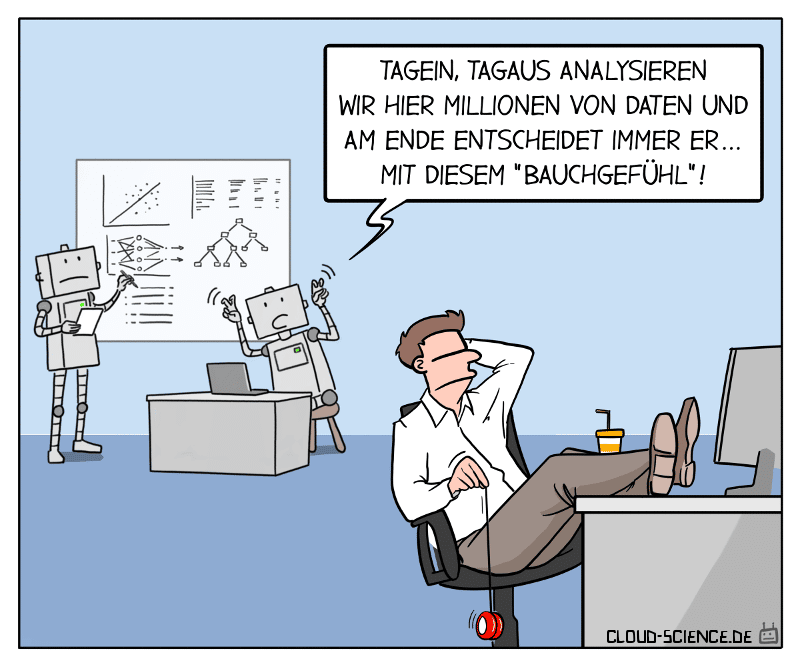

Allerdings können KI-Halluzinationen auftreten, bei denen die KI falsche Informationen liefert oder unerwartetes Verhalten zeigt. Diese Halluzinationen können in Form von falschen Nachrichten, fehlerhaften Zusammenhängen oder sogar diskriminierenden Aussagen auftreten. Die Ursachen für KI-Halluzinationen sind noch nicht vollständig geklärt, aber sie können durch Fehler bei der Kodierung und Dekodierung, unzureichende Trainingsdaten oder fehlerhafte Datenquellen verursacht werden.

Es ist wichtig, künstlicher Intelligenz (KI) kritisch zu prüfen und menschliche Kontrolle über die Ergebnisse zu behalten, um die Risiken von KI-Halluzinationen zu minimieren.