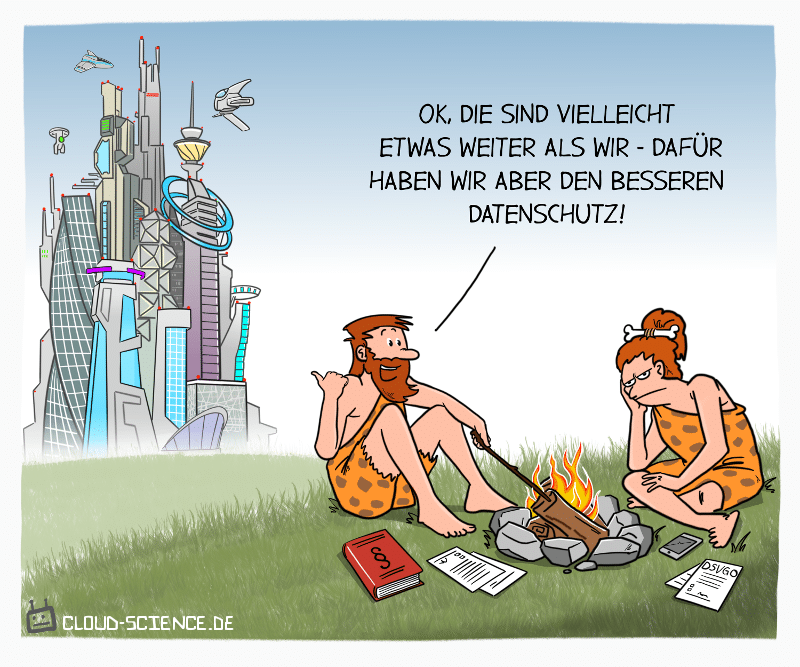

Alles hat seine Vor und Nachteile…

TechToons

Cartoons zu Daten: Datenkultur, Sammeln und Aufbereiten, Analysen, Dashboards und datenbasierte Entscheidungen. Typische Missverständnisse, Hypes und Praxisfehler knapp visualisiert.

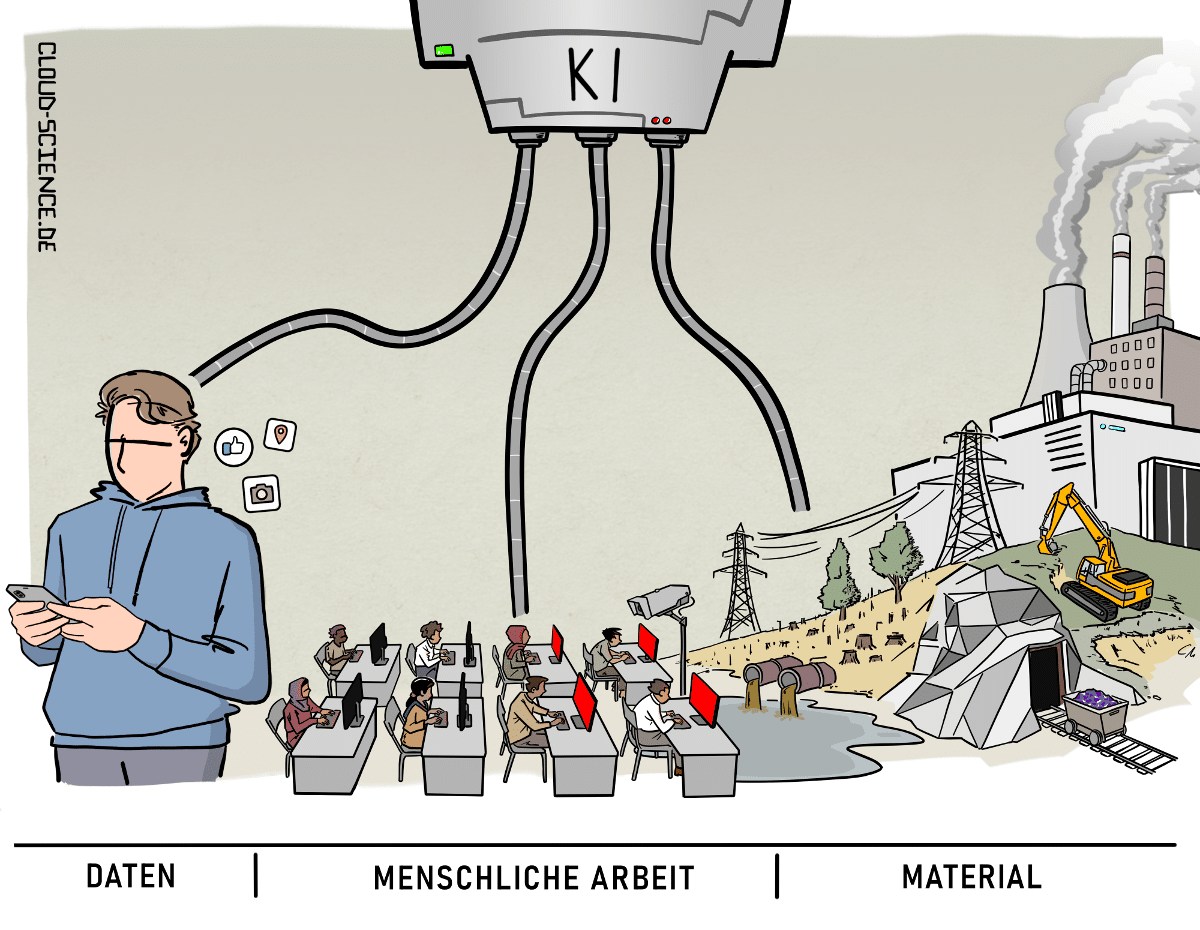

Künstliche Intelligenz entsteht nicht aus dem Nichts.

Sie fußt auf drei tragenden Säulen: der massenhaften Sammlung von Daten, der unsichtbaren Arbeit zahlloser Menschen – oft unter prekären Bedingungen – und der Ausbeutung enormer materieller Ressourcen.

Häufig wird sie mit magischen oder wundersamen Eigenschaften versehen, als handle es sich um eine körperlose Intelligenz. Hinter der glatten Oberfläche von „intelligenten“ Anwendungen verbirgt sich ein globales Netz aus Überwachung, menschlicher Klickarbeit, Energieverbrauch und Ressourcenabbau.

Vgl. Kate Crawford (2021): Atlas of AI. Yale University Press. Siehe auch Crawford & Joler (2018): Anatomy of an AI System.

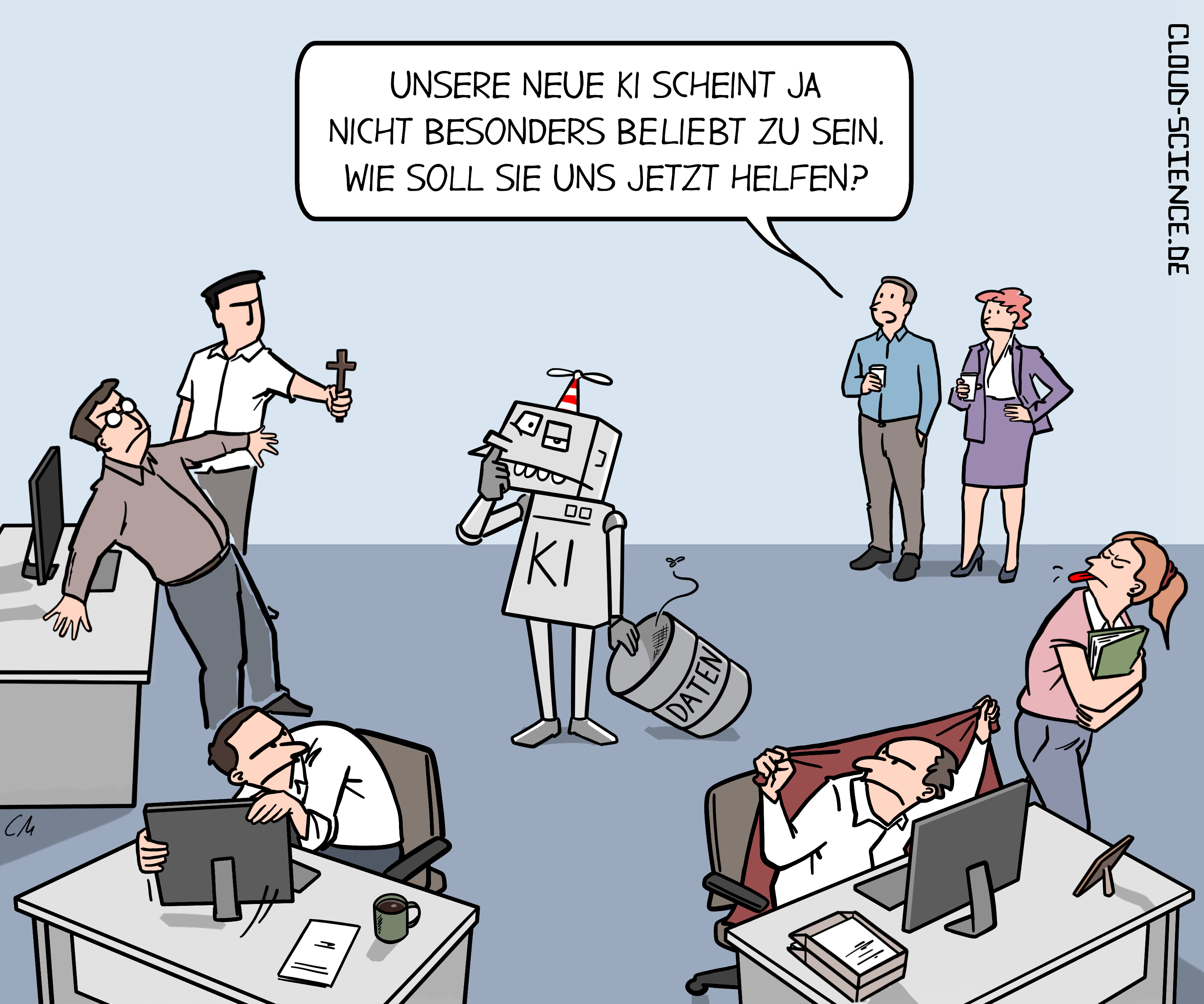

Unternehmen stehen bei KI-Einführungen oft vor kulturellen Hürden:

Wenn Mitarbeitende Akzeptanzprobleme haben, horten sie Daten statt sie zu teilen. Das führt dazu, dass KI-Systeme kaum oder gar nichts lernen und ihre Wirkung verfehlen. Der wahre Engpass liegt also weniger in der Technik als in Vertrauen, Datenkultur und transparenter Zusammenarbeit – nur wenn Informationen frei fließen, kann KI ihre Kraft entfalten.

Künstliche Intelligenz wirkt sauber, smart und autonom.

Doch hinter der glatten Oberfläche arbeiten Millionen Menschen im Verborgenen – als Datenannotator:innen.

Ausgelagert, schlecht bezahlt, psychisch belastet.

Sie klassifizieren Bilder, bewerten Texte, filtern Gewalt.

Ohne sie könnten Maschinen nichts erkennen, nichts verstehen, nichts leisten.

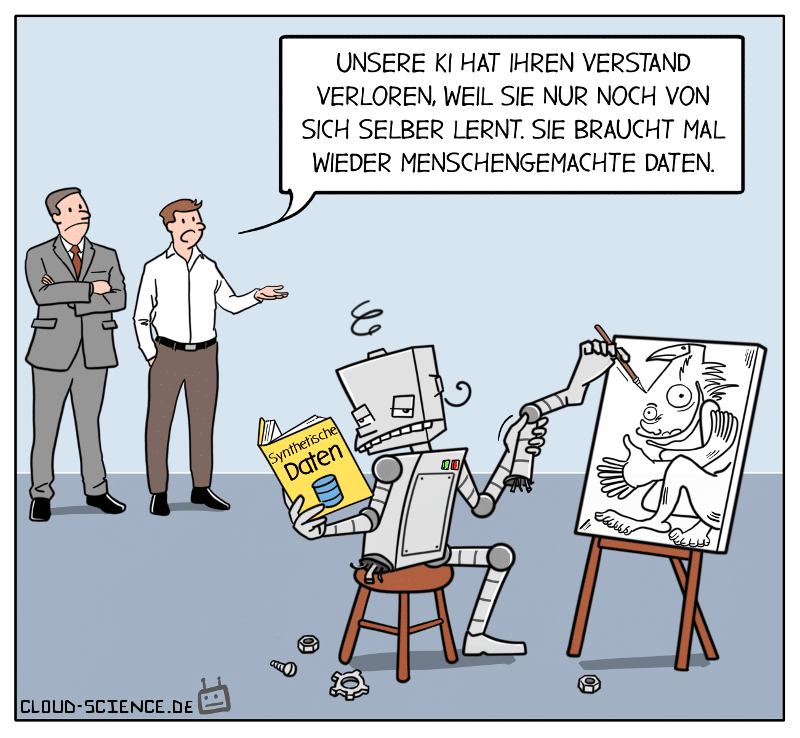

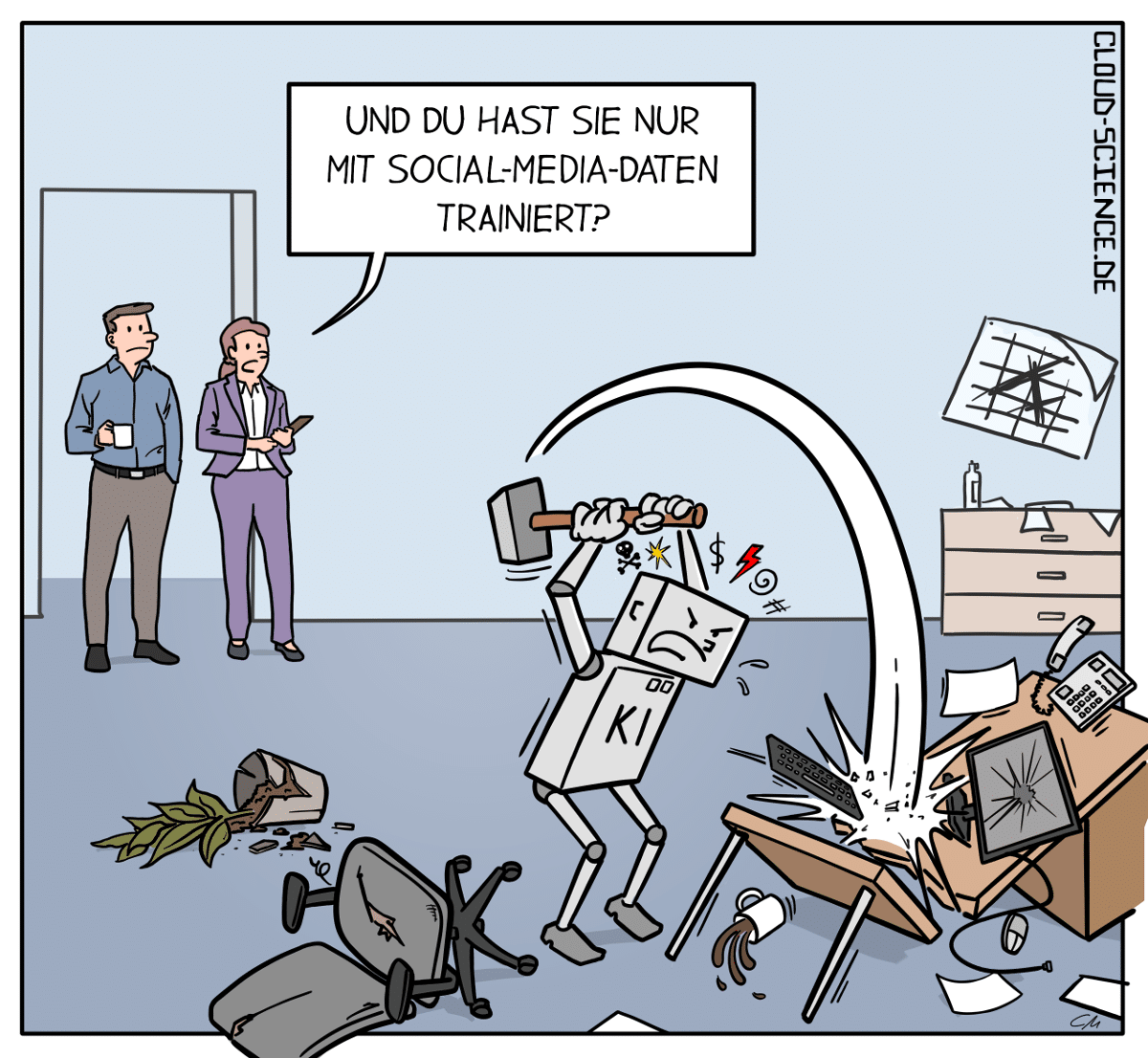

Ein Cartoon zeigt eine KI, die im Büro durchdreht – trainiert mit Social-Media-Daten, die alles andere als neutral oder objektiv sind.

Denn was in sozialen Netzwerken dominiert, ist oft emotional, populistisch, toxisch oder schlichtweg belanglos. Wenn eine KI daraus „lernt“, übernimmt sie die verzerrten Weltbilder – mit fatalen Folgen.

Das Motiv steht für ein reales Problem in der Entwicklung von KI-Systemen: Die Qualität und Herkunft der Datenbasis. Wenn diese verzerrt, lückenhaft oder oberflächlich ist, entstehen Risiken: algorithmische Fehlentscheidungen, Fehleinschätzungen und Kontrollverlust.

Ein zugespitztes Motiv für Präsentationen, Keynotes oder Fortbildungen zu den Themen AI Ethics, Datenqualität, Machine-Learning-Risiken oder Social Media als Datenquelle.

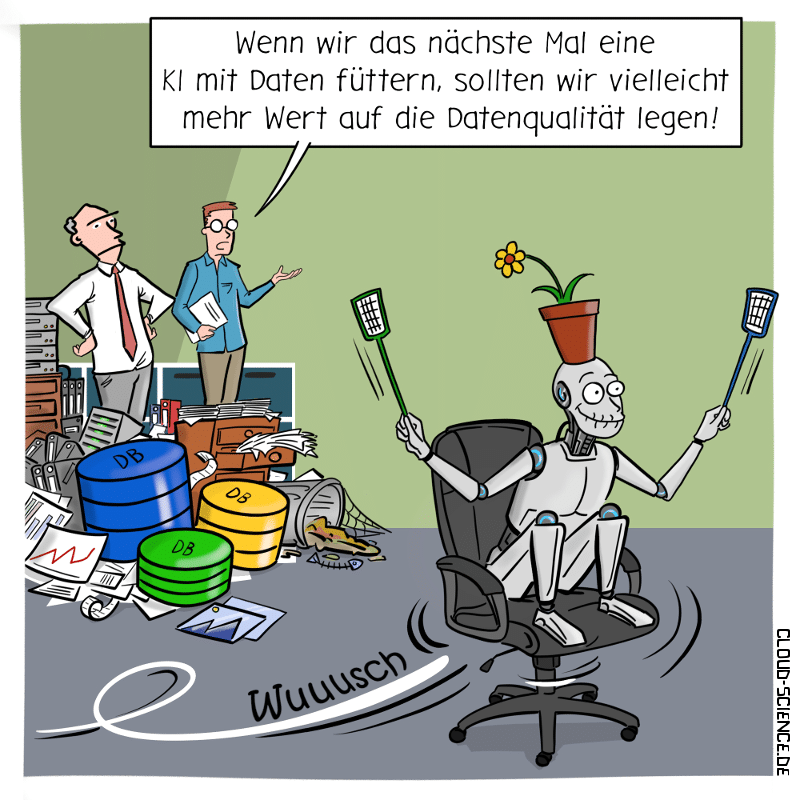

Ohne saubere Daten bringt auch die beste KI nichts – genau das macht dieser Cartoon sichtbar: „Garbage In, Garbage Out“ (Müll rein, Müll raus) . Wer Künstliche Intelligenz mit fehlerhaften, veralteten oder unsauberen Daten füttert, darf sich nicht über schlechte Ergebnisse wundern. Der Cartoon bringt mit bissigem Humor auf den Punkt, warum Datenqualität das Fundament jeder Digitalisierung ist. Ideal für alle, die das Thema Data Science, KI und Business Intelligence in Präsentationen, Fachartikeln oder Social Media ins richtige Licht rücken wollen.

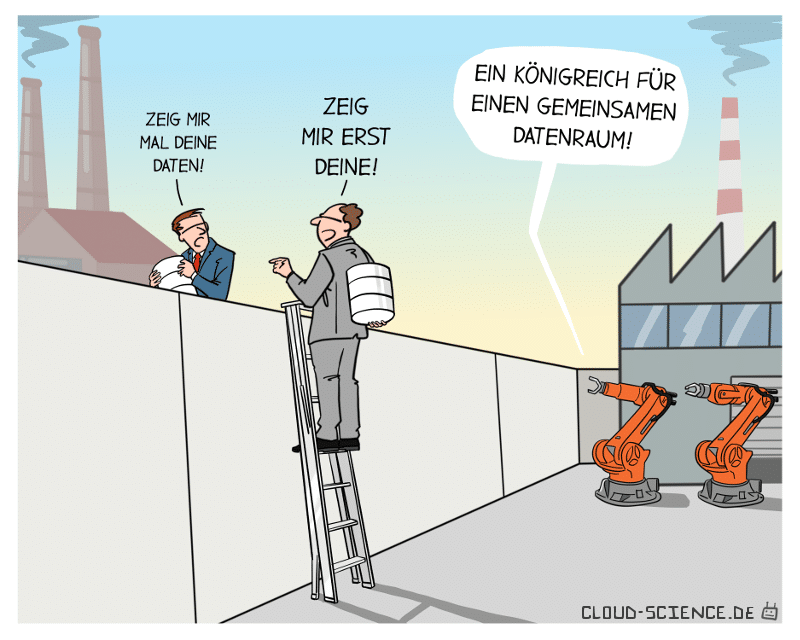

In der vernetzten Industrie soll alles geteilt werden: Daten, Prozesse, Plattformen. Doch die Realität sieht oft anders aus – jeder schützt sein System, als wäre es ein Staatsgeheimnis.

Dieser Cartoon zeigt auf bitterkomische Weise, warum die Idee gemeinsamer Datenräume in der Praxis so oft an menschlichem Misstrauen und mangelndem Vertrauen scheitert.

Model Autophagy Disorder (MAD) ist ein neues Phänomen, welches auftritt, wenn generative KI wiederholt mit von KI generierten Daten trainiert wird. Diese wiederholte Verwendung synthetischer Daten führt dazu, dass die Qualität der generativen KI-Modelle kontinuierlich abnimmt und sie ihre Fähigkeit verlieren, realistische Ergebnisse zu liefern… Die KI wird sozusagen bekloppt.

https://www.tomshardware.com/news/generative-ai-goes-mad-when-trained-on-artificial-data-over-five-times